Datautvinning

Databrytning, informationsutvinning eller datautvinning, av engelskans data mining, betecknar verktyg för att söka efter mönster, samband och trender i stora datamängder. Verktygen använder beräkningsmetoder för multivariat statistisk analys kombinerat med beräkningseffektiva algoritmer för maskininlärning och mönsterigenkänning hämtade från artificiell intelligens. Tekniker för datautvinning tillämpas inom områden som visualisering av öppna data, bioinformatik, affärsunderrättelser (business intelligence), beslutsstödsystem, webbanvändningsanalys (web mining), IT-forensik och analys av medicinska data, sensordata och mycket annat. Text mining innebär datautvinning ur icke-strukturerade data i form av text, och kan användas för maskinöversättning, automatisk sammanfattning av texter, statistisk analys av språk, med mera. Det bredare begreppet big data åsyftar även tekniker för insamling av data från flera stora databaser och datafiler till ett sökbart informationslager (data warehousing), vilket ofta föregår men inte ska sammanblandas med datautvinning. Data mining är ett trendord som åsyftar tidigare kända tekniker, och som har fått uppmärksamhet på senare år därför att dagens växande datamängder med ett stort antal variabler ofta är svåröverblickbara för människor. Dessutom kan klassiska metoder för multivariat statistisk dataanalys, exempelvis korrelationsberäkning och multipel regression, ge orimligt stor beräkningskomplexitet och fungerar därför inte vid storskalig analys. Syftet med verktyg för datautvinning är att underlätta sökandet efter strukturer bland ett stort antal variabler och leda till upptäckt av tidigare okända relationer, och på så sätt extrahera begriplig och användbar information ur rådata. Användaren av verktyg för databrytning väljer bland en uppsättning algoritmer och diagram som lämpar sig för olika typer av analys och problemställningar, och för olika typer av data. Användaren testar och jämför vilken algoritm och vilka parameterinställningar som ger bäst reliabilitet eller tydligast diagram inom rimlig beräkningstid för det aktuella problemet. Den datamängd(en) som analyseras är vanligen i form av en tabell, där varje rad eller post kan motsvara resultatet från ett mättillfälle eller för en försöksperson, och varje kolumn är en variabel eller ett attribut. Varje rad betraktas som en datapunkt i ett flerdimensionellt rum. Varje attribut har en specifik statistisk mätskala och en specifik datatyp. Ett av attributen kan ha roll som målvariabel, det vill säga den variabel vi vill träna självlärande algoritmer att prediktera. Arbetssättet vid databrytning baseras på exploratativ dataanalys(en) (EDA), som innebär att man omväxlande kombinerar verktygets automatiserade beräkningar med visualisering och manuell observation. Syftet med EDA är att hjälpa forskaren att upptäcka nya okända relationer som kan åskådliggöras med tydliga diagram, och att bygga nya prediktionsmodeller. Syftet är också att bedöma vilka samband som kan vara intressanta och att identifiera vilka variabler och datapunkter som förväntas ha betydelse vid prediktering av en målvariabel, och vilka som kan elimineras för att reducera beräkningstiden. Explorativ dataanalys skiljer sig från konfirmativ dataanalys (CDA) som är det traditionella arbetssättet vid kvantitativ forskning. Vid CDA formulerar man hypoteser och bygger modeller innan man påbörjar insamling och analys av experimentella data, och dataanalysen används enbart för att verifiera prediktioner genom systematisk hypotesprövning. EDA är däremot en hypotesgenererande och induktiv metod, som ger upphov till datadrivna hypoteser. EDA bör kompletteras med CDA för att undvika felaktiga slutsatser. Vid databrytning arbetar man dessutom ofta heuristiskt genom att utnyttja problemspecifik kunskap om vilken data som förväntas ha betydelse för resultatet och vilka typer av relationer som är rimliga och användbara att identifiera. Exempel på prestandamått.

Data warehouse

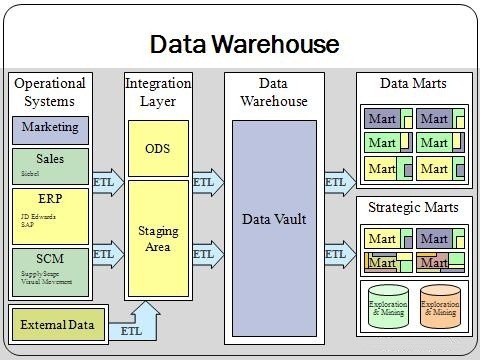

Ett data warehouse, även kallat informationslager eller datalager, är en sammanställning av information från flera källor, utförd på ett sådant sätt att det underlättar en avancerad analys av informationen. Sammanställningen har dessutom en sådan struktur, och är försedd med sådana hjälpmedel, att analysen kan utföras utan mera djupgående IT-kunskaper. Tekniker för sökbara datalager är en del av det vidare begreppet big data, som också innefattar datautvinning, det vill säga statistisk dataanalys. Ett informationslager är i praktiken alltid databasbaserat, källorna kan dock vara lagrade på flera olika sätt, på något sätt tillgängliga för informationslagret. En mångfald sätt att överföra data finns: via epost, ftp, direkta länkar mellan databaser, med flera. Analysen av informationen är normalt baserad på flera parametrar, så kallade dimensioner. En dimension motsvaras av minst en databastabell. Det data som analyseras, faktat, lagras också det i en eller flera databastabeller. Den vanligaste uppbyggnaden av ett informationslager är stjärnschemat (engelska Star Schema), där faktatabellen (eller tabellerna) omges av en dimensionstabell per dimension. Tabellerna i ett stjärnschema är denormaliserade. Strukturen påminner om en stjärna, därav namnet. En annan vanlig uppbyggnad är snöflingeschemat (engelska Snow Flake Schema), fortfarande med en eller flera faktatabeller i mitten. Dimensionstabellerna är emellertid normaliserade, vanligtvis på tredje normalformen. Man har alltså (vanligtvis) mer än en tabell per dimension, och strukturen påminner vagt om en snöflinga. I princip är stjärnschemat mer tidskrävande att bygga än snöflingeschemat, men snabbare och enklare att använda. De flesta experter tenderar att förorda stjärnscheman. Det finns även dimensionslösa informationslager. På grund av att dessa vanligtvis är betydligt mindre effektiva vad gäller söktider, används de främst för mindre datamängder. Arbetsgången när man bygger ett informationslager brukar benämnas ETL, efter de engelska orden. En viktig del av det lagrade datat är så kallad metadata, "data om data". Metadata utgörs av information som är väsentlig för användningen av informationslagret: Laddningstidpunkt, ändringstidpunkt, beskrivning av innehållet i de olika fälten, relationer mellan olika typer av data med mera. När det gäller beskrivningen av datat är det viktigt med en enhetlig namnkonvention i de fall (allt mer vanliga) då informationslagret skall användas av dotterbolag i många länder. Det är också vanligt att olika koder (landskoder, felkoder m.m.) förklaras, ofta i olika tabeller. En typisk användning för informationslager är för att underlätta för ledningen av en stor koncern att följa affärsprocesserna. Exempelvis kan man ställa en fråga om hur mycket som sålts av vissa angivna produkter i ett antal länder under vissa år. Det erhållna svaret kan presenteras på flera olika sätt, ofta i form av ett "drillbart bildskärmsdokument" men även som exempelvis grafiska diagram och rapporter på papper. Uttrycket "drillbarhet" kommer av engelskans drill-down, där begreppet avser möjlighet att borra sig ner i materialet. Ett drillbart bildskärmsdokument är ett dokument där man kan markera olika kolumner för att antingen dela upp dem på kortare dimensionsintervall eller summera dem på större intervall. Om datan i ett sådant dokument från början presenteras per månad och land kan man exempelvis välja att summera per år eller dela upp per vecka, alternativt summera per världsdelar eller dela upp per försäljningsområden/län/kommun (motsvarande). Eftersom det är brukligt i informationslagermiljö med summeringar av data är det vanligt att spara inte bara ett, utan flera olika aggregat, alltså data som summerats på de vanligaste parametrarna, för att snabba upp sökningarna i drillbara dokument. Amerikanen Bill Inmon, som var en av de första som definierade begreppet Data warehouse, satte upp fyra krav på ett informationslager.